Sztuczna inteligencja to jedno z najbardziej przełomowych osiągnięć współczesnej technologii. Dzięki niej komunikujemy się z asystentami głosowymi, tłumaczymy teksty w czasie rzeczywistym, diagnozujemy choroby i automatyzujemy procesy biznesowe. Jednak mimo niezwykłego potencjału, AI nie jest wolna od błędów. Czasem podaje informacje, które wyglądają na wiarygodne, ale w rzeczywistości są całkowicie zmyślone. Czy to znaczy, że sztuczna inteligencja kłamie? Aby odpowiedzieć na to pytanie, musimy zrozumieć zjawisko tzw. halucynacji AI.

Co to są halucynacje w AI?

Halucynacje w kontekście sztucznej inteligencji nie mają nic wspólnego z ludzkim postrzeganiem rzeczywistości. To określenie opisuje sytuację, w której system AI – np. chatbot lub model językowy – generuje odpowiedzi, które są nieprawdziwe, wymyślone lub niezgodne z faktami. Co więcej, taka odpowiedź może być przedstawiona w sposób przekonujący, spójny gramatycznie i logiczny, co utrudnia jej wychwycenie przez użytkownika.

W praktyce może to wyglądać tak, że AI tworzy cytaty, które nigdy nie padły, przypisuje wypowiedzi niewłaściwym osobom, wymyśla nieistniejące książki czy błędnie opisuje wydarzenia historyczne. W efekcie użytkownik otrzymuje fałszywe informacje, które mogą prowadzić do dezinformacji, błędnych decyzji czy nieporozumień.

Co to są halucynacje AI?

Choć pojęcie halucynacji AI jest synonimiczne z wcześniej opisanym terminem, warto zwrócić uwagę na jego szczególne znaczenie w kontekście rozwoju modeli językowych. Halucynacje AI to efekt uboczny działania systemów opartych na dużych zbiorach danych, które uczą się schematów, ale nie mają świadomości ani zdolności do weryfikowania faktów.

System AI nie „wie”, czy to, co mówi, jest prawdą. Nie ma dostępu do rzeczywistości ani intencji kłamstwa – generuje tekst na podstawie prawdopodobieństwa, a nie weryfikowalnych źródeł. To właśnie odróżnia go od człowieka. Nie możemy więc mówić o celowym kłamstwie – raczej o błędnym wnioskowaniu na podstawie niepełnych danych lub błędów w modelu.

Jakie są źródła halucynacji u AI?

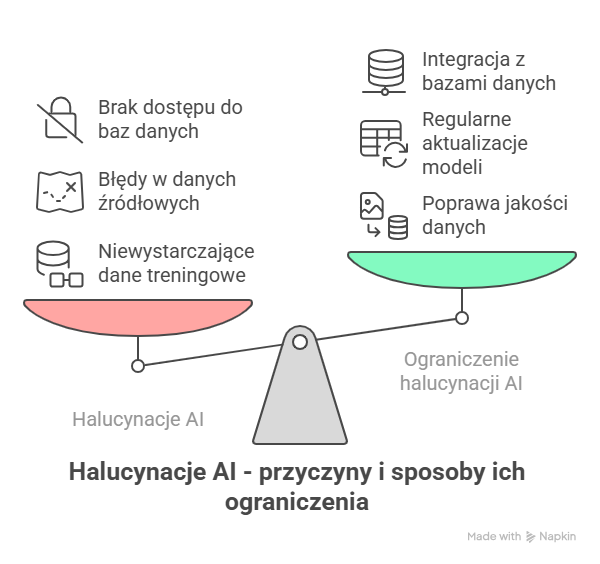

Halucynacje w AI mają wiele przyczyn – zarówno technicznych, jak i związanych z jakością danych treningowych. Do najczęstszych źródeł halucynacji u AI należą:

1. Niewystarczające dane treningowe

Jeśli model był trenowany na niekompletnych lub zniekształconych danych, może tworzyć fałszywe odpowiedzi. Przykładowo – brak dostępu do aktualnych informacji może skutkować przedstawianiem nieaktualnych lub nieprawdziwych danych.

2. Błędy w danych źródłowych

Modele uczą się na podstawie tego, co „czytają” w internecie i innych zbiorach tekstu. Jeśli w tych źródłach znajdują się błędy, dezinformacja lub nieprawdziwe treści, AI przejmuje je jako „wzorce” do generowania tekstów.

3. Brak dostępu do zewnętrznych baz danych

Wiele modeli AI nie ma możliwości przeszukiwania internetu w czasie rzeczywistym ani korzystania z wiarygodnych źródeł. Ich odpowiedzi bazują jedynie na tym, co zostało zapisane w pamięci modelu podczas treningu.

4. Nadmiarowy optymizm modelu

Modele AI często próbują zadowolić użytkownika i odpowiedzieć na każde pytanie, nawet jeśli „nie wiedzą”, jaka jest prawidłowa odpowiedź. Zamiast przyznać się do braku wiedzy, wolą wygenerować najbardziej prawdopodobną odpowiedź – nawet jeśli jest ona nieprawdziwa.

Jak ograniczyć halucynacje AI?

Choć całkowite wyeliminowanie halucynacji AI jest dziś technicznie niemożliwe, istnieje wiele metod ograniczających to zjawisko. Kluczowe są działania podejmowane zarówno na etapie tworzenia modeli, jak i podczas ich użytkowania.

1. Poprawa jakości danych treningowych

Im lepsze dane, tym mniejsze ryzyko generowania fałszywych odpowiedzi. Ważne, aby dane były wiarygodne, aktualne i pochodziły ze sprawdzonych źródeł.

2. Regularne aktualizacje modeli

Świat się zmienia, a wraz z nim zmieniają się informacje. Modele, które nie są aktualizowane, narażone są na generowanie nieaktualnych lub nieprawdziwych treści. Dlatego coraz więcej firm dba o cykliczne aktualizowanie swoich rozwiązań AI.

3. Integracja z bazami danych i wyszukiwarkami

Zaawansowane modele AI mogą być połączone z internetowymi bazami wiedzy lub wyszukiwarkami. Dzięki temu potrafią weryfikować informacje i powoływać się na konkretne źródła, co zmniejsza ryzyko halucynacji.

4. Budowanie modeli z funkcją odrzucania odpowiedzi

Niektóre systemy uczone są także tego, że mogą nie znać odpowiedzi. Zamiast wymyślać odpowiedź, uczą się przyznawać do niewiedzy – co może być cenniejsze niż generowanie nieprawdy.

5. Rola użytkownika – weryfikacja AI

Korzystając z AI, warto zawsze podchodzić do odpowiedzi z rezerwą. Jeśli dana informacja wydaje się zaskakująca lub kluczowa dla podjęcia decyzji – należy ją samodzielnie sprawdzić w wiarygodnym źródle.

Sztuczna inteligencja kłamie? – podsumowanie

Czy można powiedzieć, że sztuczna inteligencja kłamie? W sensie ludzkim – nie. AI nie ma intencji, nie rozróżnia prawdy od fałszu, nie potrafi ocenić skutków swoich słów. To narzędzie, które działa na podstawie statystyki i prawdopodobieństwa. Gdy generuje nieprawdziwe informacje, mówimy o halucynacjach – czyli błędach w działaniu modelu.

Wiedza o tym, co to są halucynacje w AI, jakie są ich źródła oraz jak ograniczyć halucynacje AI, pozwala mądrzej i bezpieczniej korzystać z nowoczesnych technologii. Sztuczna inteligencja nie jest doskonała – ale z odpowiednią świadomością jej użytkowników może być bardzo użyteczna i skuteczna. Kluczem jest krytyczne myślenie i umiejętność weryfikacji informacji.